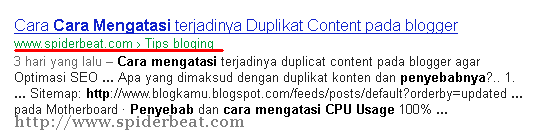

Berdasarkan pengalaman saya sendiri,blog wordpress sangat rentan sekali untuk timbul duplicat content.Duplicate content yang saya maksud adalah seperti duplicat metatag atau duplicate titletag.Hal ini hanya bisa diketahui jika kita mengecek di www.google.com/webmaster > Optimization >HTML Improvements.

Jika memang ada terjadi duplicat content,maka akan dilaporkan secara mendetail disana.Dan jika tidak ada masalah dengan duplicate content,akan ada pesan seperti ini:

Last updated May 28, 2012

We didn’t detect any content issues with your site. As we crawl your site, we check it to detect any potential issues with content on your pages, including duplicate, missing, or problematic title tags or meta descriptions. These issues won’t prevent your site from appearing in Google search results, but paying attention to them can provide Google with more information and even help drive traffic to your site. For example, title and meta description text can appear in search results, and useful, descriptive text is more likely to be clicked on by users.

Duplicate content terjadi karena ada satu halaman blog dengan dua alamat URL yang berbeda.Atau banyak halaman yang berbeda,tetapi memilkiki title yang sama.

Saran saya supaya Selalu rajin memantau kesehatan blog kamu diwebmaster tool agar segera bisa tertangani dan tidak sampai menumpuk hingga puluhan bahkan ratusan.

Banyaknya duplicate content pada blog akan menjadi kurang baik blog dimata mesin pencari google ,karena kontent blog akan dianggap tidak berkualitas dan bahkan menyesatkan pembaca.

Tentu hal Ini tidak baik bagi pemeringkatan blog di result mesing pencari google,karena algoritma mesin pencari google lebih menyukai kontent yang unik untuk menempati urutan result atas.

Kesimpulan saya, hindari terjadinya duplikat content ini seminimal mungkin.Seperti yang saya katakan diawal paragraf ini bahwa wordpress(self hosting) lebih rentan terjadi duplicate content,namun jangan khawatir,karena ada masalah pasti ada jalan keluar.

Untuk mengatasi agar tidak terjadi duplicate content diblog WP,kamu bisa memasang plugin gratis yang bernama All in One SEO Pack , atau sekaligus juga memasang file robots.txt.

Dalam postingan ini ,saya akan share pengalaman saya yaitu bagaimana cara membuat robot.txt.

Cara mengatasi duplicate content dengan membatasi halaman dengan robots.txt pada blog wordpress.

Pada intinya ,file robots.txt ini berisi perintah khusus untuk membatasi crawl mesin pencari agar mengindex ataupun tidak kepada dokumen html tertentu .

Pada saat crawl mengunjungi sebuah situs/blog,maka yang dicari pertamakali adalah file robots.txt sebelum mengcrawl dokumen index/halaman index blog.

Contoh penulisan perintah robots.txt

Perintah Disallow adalah perintah untuk tidak mengindex page tersebut

Perintah Allow adalah untuk memerintahkan mengindex page tersebut

Cara pemasangan file robots.txt dan isi perintahnya secara umum jika untuk blog wordpress.

(berikut ini bukan sekedar contoh,namun ini juga yang saat ini saya pakai di blog WP saya)

User-agent: Googlebot

Disallow: /wp-content/

Disallow: /wp-admin/

Disallow: /info/

Disallow: /author/admin/page/*/

Disallow: /*/page/

Disallow: /page/*/

Disallow: /*/*/page/*/

Disallow: /wp-includes/

Disallow: /wp-

Disallow: /*/feed/

Disallow: /trackback/

Disallow: /plugins/

Disallow: /cgi-bin/

Disallow: /?random/

Disallow: /author/

Disallow: /tv/

Disallow: /css/

Disallow: /img/

Disallow: /*/comment-page-*

Allow: /wp-content/uploads/

User-agent: *

Disallow: /wp-content/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-

Disallow: /*/feed/

Disallow: /trackback/

Disallow: /plugins/

Disallow: /adlogger/

Disallow: /cgi-bin/

Disallow: /?random/

Disallow: /author/

Disallow: /author/admin/page/*/

Disallow: /*/page/

Disallow: /page/*/

Disallow: /*/*/page/*/

Disallow: /tv/

Disallow: /css/

Disallow: /img/

Disallow: /*/comment-page-*

# Google Image

User-agent: Googlebot-Image

Allow: /*

# Google AdSense

User-agent: Mediapartners-Google*

Disallow:

Allow: /*

# digg mirror

User-agent: duggmirror

Disallow: /

Sitemap: http://www.namablogmu.com/sitemap.xml

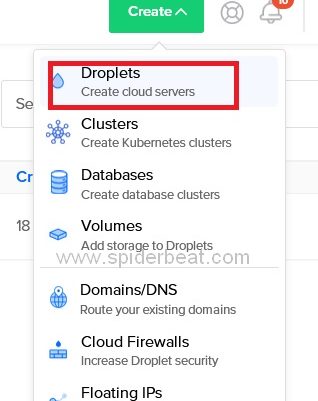

Copy dan paste code robots.txt diatas kedalam notepad dengan nama robots.txt lalu upload kedalam direktori hosting dimana CMS wordpress kamu terinstall.Sehingga nantinya file robots.txt itu berada sama sama didalam folder www bersama dengan file file wordpress lainnya.

Cara lain untuk membuat file robots.txt bisa juga langsung melalui c-Panel hosting, direktori > created new file > kasih nama dengan robots.txt > edit > masukkan code diatas > Save.

Untuk memastikan apakah robots.txt sudah terpasang dengan baik atau tidak,cobalah dipastikan dengan cara mengakses alamat URLnya yaitu http://www.namablogmu.com/robots.txt.Jika memang sudah benar maka code robots.txt diatas akan tampil di browser kamu.

Hanya Untuk melengkapi biar afdol (jika belum),install lah plugin google sitemap xml ,cari saja melalui add new plugin di admin area wp kamu.Plugin ini berguna untuk membuat file sitemap.xml secara otomatis.Jangan lupa jika sudah selesai menginstal plugin ini untuk meng add sitemap blog kedalam www.google.com/webmaster.

Masih agak bingung soal robot.txt 🙁

Luar biasa, bisa di terapin di blog gratisan seperti saya mantaaaap mas 😀

untuk di blogspot bagaimana caranya?

untuk opencart gimana caranya?

kode bintang"*" itu fungsinya apa Gan…???

Makasih mas…

segera saya praktekkan

sukses selalu

rekues gan robot.txt untuk joomla

Kl ada yg opencart tolong dishare ya.

TQ

www.Butterfly-Shopz.com

makasi boz untuk tipsnya…..

Software Full

http://softdown32.net

Ilmu yang sangat bermamfaat bro, smoga ada yang membalas kebaikan mas bro..

thanks

www.annabila.com

mas cara itu supaya agar google tidak mengindex duplicate konten tersebut kan? nah bagaimana cara menghilangkan link duplikat konten tersebut dari blog kita selamanya?

Selama ditambahakan disalow pada robots.txt, ya selamanya tak akan muncul lagi.

Perlu diketahui, yang perlu dimasukkan kedaftar robot.txt adalah halaman yang menimbulkan duplikat kontent, namun tak mungkin untuk dihapus maupun diedit.

Jika bisa diperbaiki dengan cara diedit, sebaiknya diedit, biasanya pada kasus memberikan semua deskripsi sendiri-sendiri disetiap postingan yang sama,jika menggunakan salah satu fitur plugin semacam All in One SEO Pack.

Saran: Untuk blog WP, gunakan plugin SEO, bisa All in One SEO Pack, atau SEOby Yoast, dll untuk meminimalisir duplikat content.

Untuk yg Blogspot gimana ni gan,…

Mau memasangnya tapi masih takut kalau ada yang eror, bisa kasih solusi gak mas buat saya, gimana pemasangan yang benar dari robot.txt ini.

Mas Supri.

Itu yang pas bagian digg mirror user agentnya memang duggmirror atau diggmirror, saya takut salah.

Terima kasih sebelumnnya.

Digg Mirror tersebut adalah cara lama,dan mungkin sekarang sudah tidak berguna lagi.Boleh dihapus saja semuanya ,yaitu:

# digg mirror

User-agent: duggmirror

Disallow: /

Kalaupun toh dibiarkan, nggak akan mempengaruhi robot.txt secara keseluruhan.

kalo untuk tidak mengindex halaman privacy, about, contact, bagaimana ya bos.. saya sudah pakek robot.txt di atas, tp halaman tsb diats masih keindex.. thanks boz

Menurut pendpat saya, pengindexan halaman statis tdk menimbulkan masalah(duplicat conten).

Saya sudah sering membatasi kontent yang tdk saya kehendaki untk diindex dg robots.txt,dan selalu berhasil kok.

Bisa saja dibatasi kalau memang dikehendaki,untuk blogger contohnya hanya tinggal menambahkan halaman mana yang dimauin:

Disallow: /p/privacy.html

Gitu saja kok

Semoga membantu,trims telah berkunjung 😀

Bagus bos sangat membantu untuk blog saya. Cuman belum ada postingan tentang cara membuat robots.txt untuk opencart … kalo boleh berbagi pengalaman nya ya. trimakasih.

Open cart ane belum pernah nyoba,namun yang jelas susunannya sama sebenarnya.Cuma yang membedakan adalah susunan direktori yang nggak /boleh diindex apasaja.

Misalnya direktori Admin page pada WP nggak boleh diindex, perintahnya adalah: Disallow: /admin/

Coba dilihat di webmaster tools,halaman mana saja yang membuat duplicate title/deskripsi

Terimakasih telah berkunjung

Good post, sangat bermanfaat sekali buat saya, terimakasi,

thanks boss.. ini sangat membantu saya memahami fungsi dari perintah2 robot.txt,. success 4 admin

bisa bikinin yang blogspot gak bro 🙂

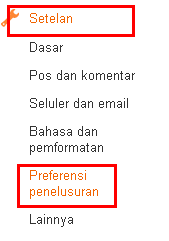

@wong edan

Saya rasa blogspot cukup hanya menambahkan canonical, metatag standard sudah aman.Walau sebenarnya antarmuka baru sudah menyediakan fitur robots.txt

WP lebih rentan duplikat content,menurut pengalaman ane..

wah, kalau buat blogspot gi,ana nih kang?

Boleh juga saya coba nih, makasih gan tipsnya…